Face picture style conversion method and device, electronic equipment and storage medium

A style conversion and picture technology, applied in the field of face recognition, can solve the problems of low richness of training data, high cost of attack masks, poor accuracy of generalization ability of human face detection model, etc., to ensure security and improve generalization Effects of Power and Accuracy

- Summary

- Abstract

- Description

- Claims

- Application Information

AI Technical Summary

Problems solved by technology

Method used

Image

Examples

Example Embodiment

[0060]为了能够更加详尽地了解本公开实施例的特点与技术内容,下面结合附图对本公开实施例的实现进行详细阐述,所附附图仅供参考说明之用,并非用来限定本公开实施例。在以下的技术描述中,为方便解释起见,通过多个细节以提供对所披露实施例的充分理解。然而,在没有这些细节的情况下,一个或多个实施例仍然可以实施。在其它情况下,为简化附图,熟知的结构和装置可以简化展示。

[0061]本公开实施例的说明书和权利要求书及上述附图中的术语“第一”、“第二”等是用于区别类似的对象,而不必用于描述特定的顺序或先后次序。应该理解这样使用的数据在适当情况下可以互换,以便这里描述的本公开实施例的实施例。此外,术语“包括”和“具有”以及他们的任何变形,意图在于覆盖不排他的包含。

[0062]除非另有说明,术语“多个”表示两个或两个以上。

[0063]本公开实施例中,字符“ / ”表示前后对象是一种“或”的关系。例如,A / B表示:A或B。

[0064]术语“和 / 或”是一种描述对象的关联关系,表示可以存在三种关系。例如,A和 / 或B,表示:A或B,或,A和B这三种关系。

[0065]术语“对应”可以指的是一种关联关系或绑定关系,A与B相对应指的是A与B之间是一种关联关系或绑定关系。

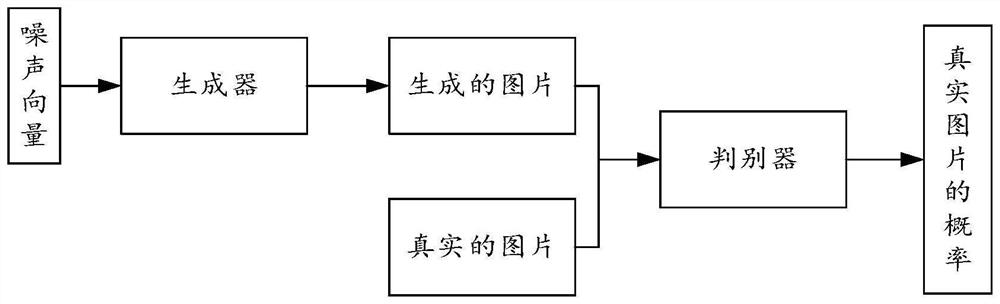

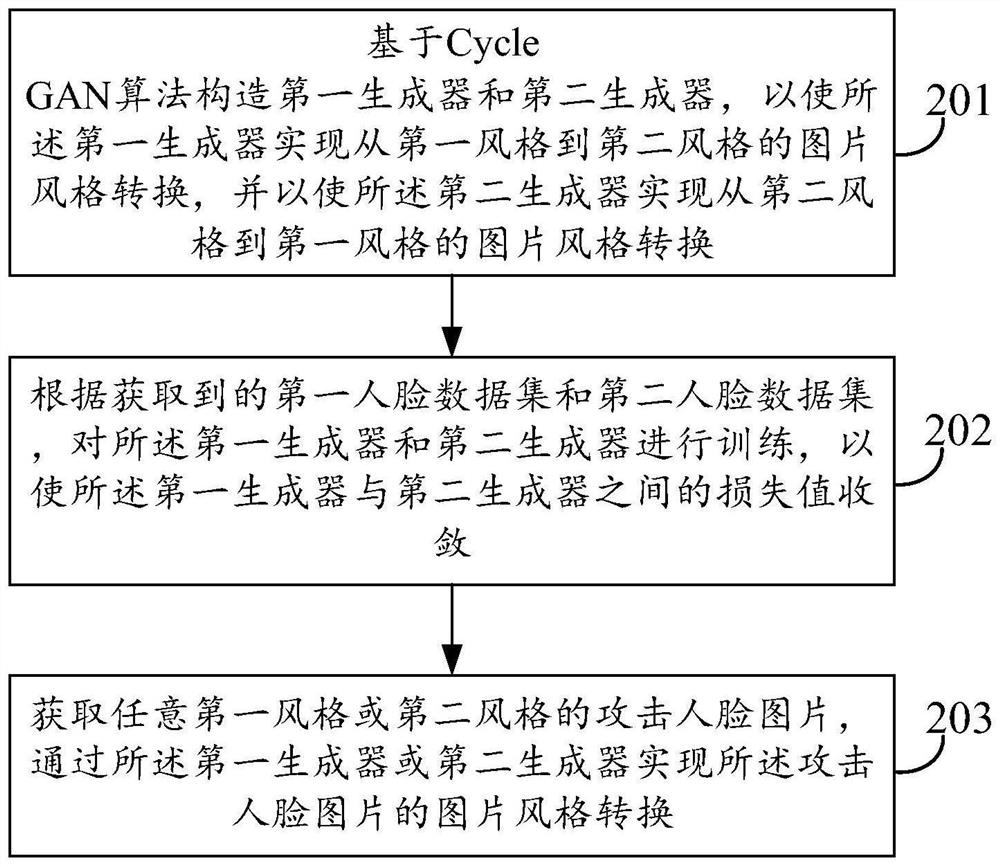

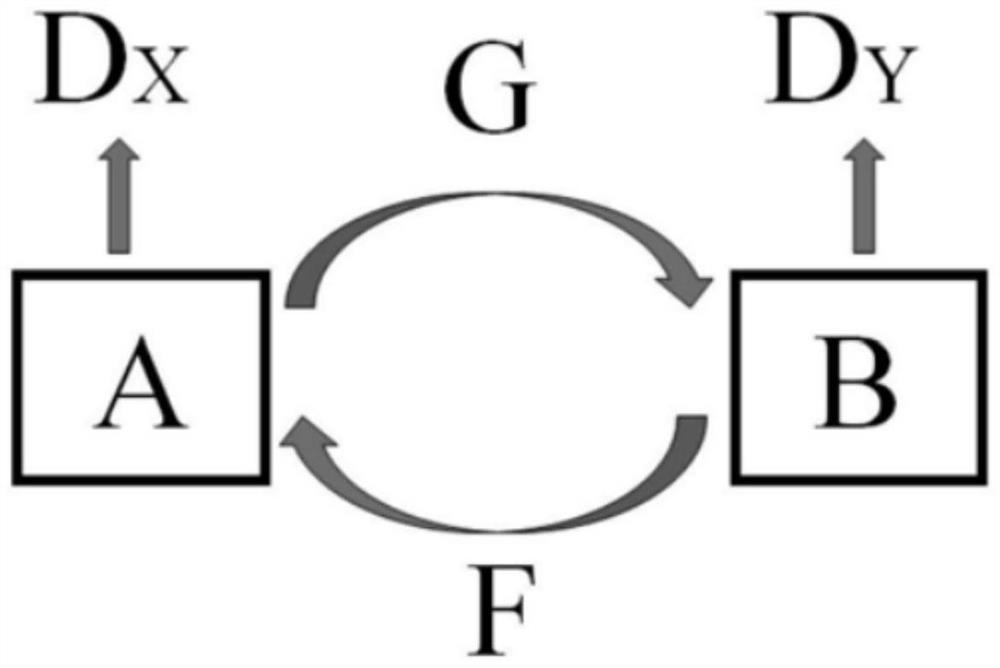

[0066]结合图1所示,生成对抗网络(Generative Adversarial Network,GAN)是通过生成器(Generator)和判别器(Discriminator)不断博弈,进而使生成器学习到数据的分布的神经网络学习模型。在训练过程中,生成器的目标就是尽量生成看起来真实的图片去欺骗判别器。而判别器的目标就是尽量辨别出生成器生成的图片和真实的图片。这样,生成器和判别器构成了一个动态的“博弈过程”,最终双方博弈的结果就是,生成器生成的假样本与真样本几乎没有差别,从而导致判别器不能区分真样本还是假样本,此时生成器和判别器达到了平衡,整个训练过程结束。

[0067]在相关技术中,大量GAN模型,例如Cycle GAN、Big GAN和Style GAN已经被研发应用于从随机噪声输入生成高质量多样化的生成图片。近来研究表明,GAN可以在中间特征和隐层空间有效编码富语义信息。这些理论可以通过改变隐层空间编码,合成具有变化多样特性的图片。

[0068]在相关技术中,人脸识别系统面临诸多安全上的风险,为了应对这一挑战,训练一个人脸活体检...

PUM

Login to View More

Login to View More Abstract

Description

Claims

Application Information

Login to View More

Login to View More - R&D

- Intellectual Property

- Life Sciences

- Materials

- Tech Scout

- Unparalleled Data Quality

- Higher Quality Content

- 60% Fewer Hallucinations

Browse by: Latest US Patents, China's latest patents, Technical Efficacy Thesaurus, Application Domain, Technology Topic, Popular Technical Reports.

© 2025 PatSnap. All rights reserved.Legal|Privacy policy|Modern Slavery Act Transparency Statement|Sitemap|About US| Contact US: help@patsnap.com